En effet, à mon sens, cela dépendra de l'usage qu'on en fera.

Dans certains cas : pas trop d'intérêts, mais peut-être dans d'autres, la multiplication peut être avantageuse.

Mon interprétation (vulgarisée) est la suivante :

En fait, on a toujours le même problème, même si on le repousse (mais de plus en plus difficilement

avec les méthodes actuelles) : la taille minimale actuelle des photosites pose problème.

Ex : les "Full Frame" deviennent de plus en plus fréquents, car c'est plus facile d'en coller plus si on dispose de plus d'espace...

Et les autres : du bricolage software et des mathématiques...

Un "photosite" et ses composants élémentaires se heurtent à des problèmes qu'une nouvelle technologie devra résoudre

(sauf si on passe au capteur "biologique", où va descendre d'un cran en taille..

).

Même problème que pour les mémoires informatiques : on n'a rien fait de mieux que l'ADN pour stocker des informations...

Donc, actuellement, à une taille "physique" donnée, comment optimiser ?

Si on regarde un objet dont les photons représentatifs arriveront sur 16 "photosites"

(disons 16 µ, pour simplifier) de taille à la capture, toutes les variations de "1 pixel"

sont évidemment possibles, rien de nouveau :

Sans matrice couleur

16 x 1 = moins de sensibilité, plus de description, pas de qualification

4x4 = sensibilité moyenne, description moyenne, pas de qualification

16 = sensibilité max, description faible, pas de qualification

Bref : "binning"...

Et il faudra plusieurs captures (= plus de temps d'observation + qualité des filtres)

pour obtenir une information plus complète, mais "interprétée" aussi !

=> le passage vers une valeur liée à l'addition des informations capturées est en soi aussi une

interprétation... (ok là, j'arrête, car il faudra sortir l'aspirine...

)

Donc, l'évolution de la matrice "standard" (RGGB) est liée à une interprétation

humaine....

Et pour l'usage de la capture d'image à vocation d'interprétation humaine (ou d'aide à la conduite, par exemple).

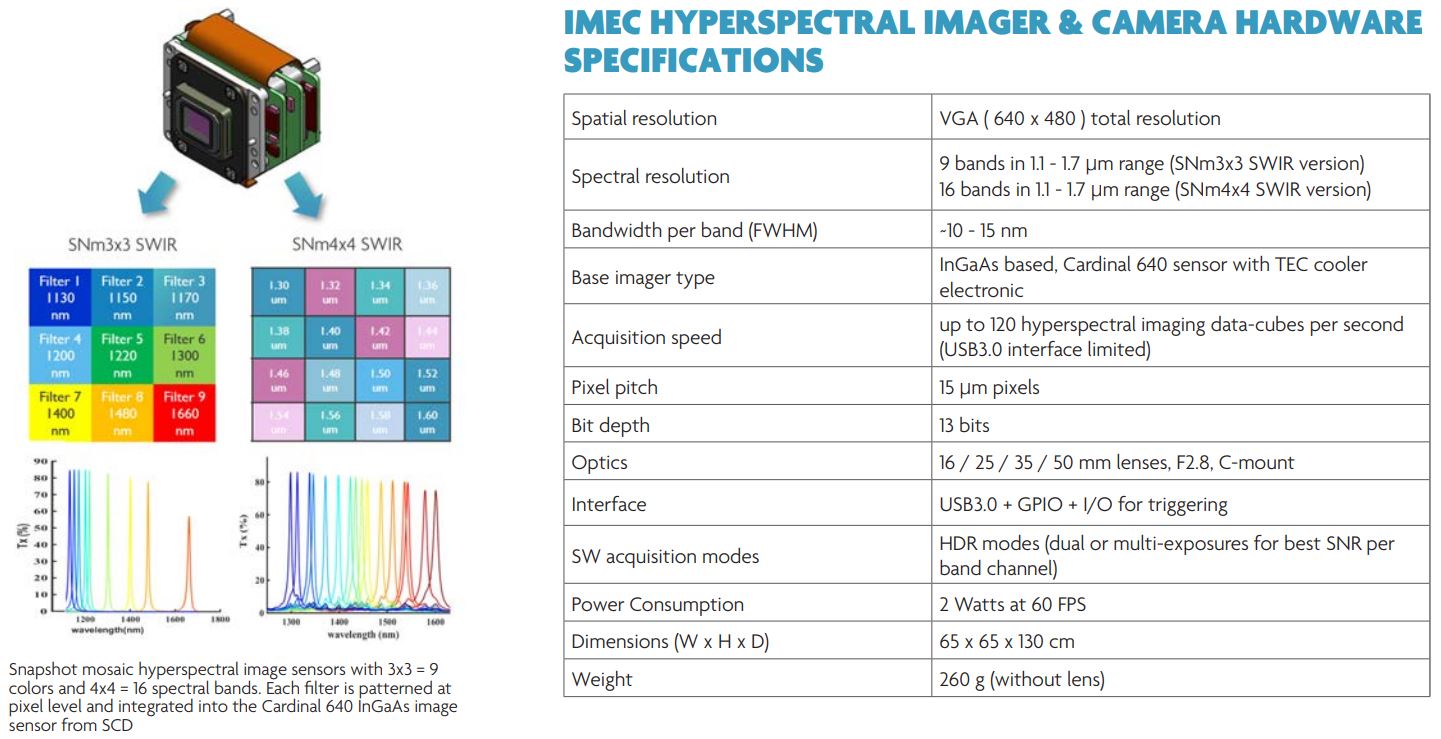

Il en découle que les mêmes études "physiques" vont mener plus loin que le "RGB", les capteurs du futur seront dans ce genre-çi

Mais regardez la consommation actuelle ! 2W à 60 fps pour une résolution VGA !

Et la chaleur accumulée = bruit... Etc, et on est reparti pour un tour.

Donc, pour le côté "humain" et "interprétation" de ce qui se passe sous notre soleil...

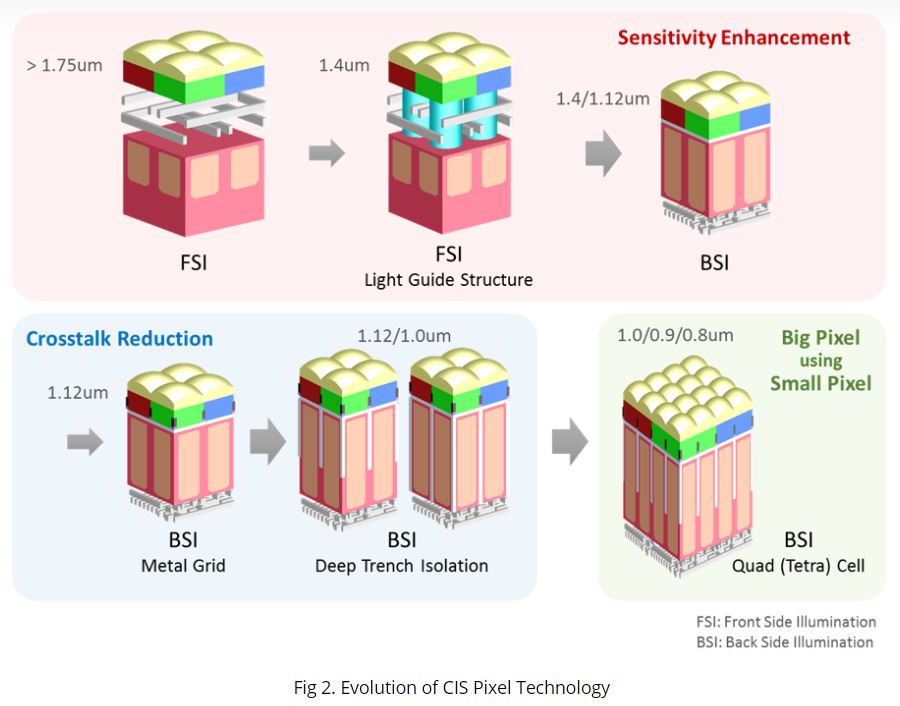

Il y a donc plusieurs "écoles" de "quad pixel captor" qui va vouloir augmenter l'aspect

"qualité" et "sensibilité" à surface de capteur égale.

Et actuellement, on parvient visiblement mieux à "caser" des photosites qui

collaborent ensembleque d'assembler des photosites

indépendants sur une même surface utile.

Donc, souvent en "quad", ce n'est PAS "4" plus petits = mais bien "4 parties" d'un seul même à l'origine.

On a "découpés" optiquement (via micro-lentilles) la surface du photosite en 4.

Et en interprétant les 4 "zones", on essaie visiblement d'extraire plus d'information.

D'autres techniques de "découpes" (incluant la partie de capteur et une isolation du chemin optique) existent, ex :

Donc... En Astro, si j'imagine que l'on regarde une exoplanète dont la lumière captée fait 16 photosites...

On aura en finale la même "quantité" d'information que 4x4, mais on saura mieux (16x16) comment se

répartissent les photons dans chaque couleur...

Et le "bleu" pourrait (peut-être) être caractérisé tout de suite ?